56 résultats sur 56 entrées

FIDLE / CNRS

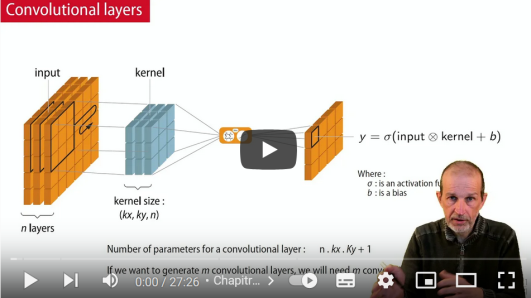

CNN : Les Réseaux convolutif

Intelligence Artificielle Réseaux convolutif

CNN : Les Réseaux convolutif Lorsque les données deviennent trop importantes, dans les cas des images mais pas seulement, les réseaux convolutifs sont incontournables ! Principes et concepts des réseaux convolutifs. Convolutions et paramètres associés.

Effort : 0,5h Rythme : Auto-rythmé

FIDLE / CNRS

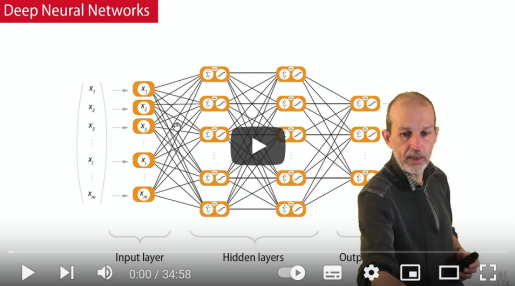

Introduction au Deep Learning Session 1

Intelligence Artificielle Introduction au Deep Learning

Formation Introduction au Deep Learning (Fidle) - Séquence 01

Effort : 3h Rythme : Auto-rythmé

FIDLE / CNRS

Introduction au Deep Learning Session 2

Intelligence Artificielle Introduction au Deep Learning

Formation Introduction au Deep Learning (Fidle) - Séquence 02

Effort : 2h Rythme : Auto-rythmé

FIDLE / CNRS

Contexte et outils, séquence 1

Intelligence Artificielle Outils pour l’IA

Le Deep Learning expliqué, en séquences courtes ! Méthode scientifique et IA : Intelligence artificielle, machine learning et Deep Learning, quelles différences ? Apprentissage supervisé, non supervisé : les grandes familles du ML.Quels outils et comment faire du Deep Learning ?

Effort : 0,4h Rythme : Auto-rythmé

FIDLE / CNRS

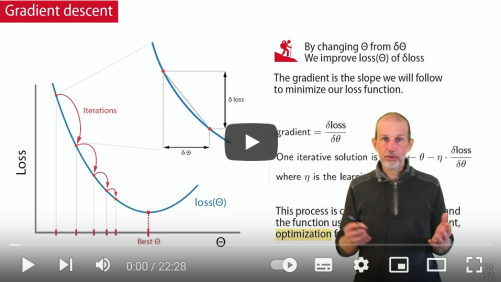

De la régression linéaire au neurone artificiel, Séquence 2

Intelligence Artificielle Outils pour l’IA : Regresseion et Neurone artificiel

Le Deep Learning expliqué, en séquences courtes ! Comprendre la régression linéaire et la régression logistique pour comprendre ce qu’est un neurone artificiel ! Dans cette vidéo, nous découvrirons ce qu’est un neurone artificiel, quels sont les grands principes de la descente de gradient et les limites des solveurs linéaires ou des réseaux à 1 neurone 😉

Effort : 0,4h Rythme : Auto-rythmé

FIDLE / CNRS

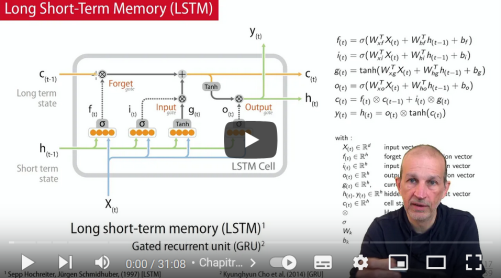

RNN : Réseaux récurrents

Intelligence Artificielle RNN : Réseaux récurrents, LSTM, GRU

RNN : Réseaux récurrents Les données séquentielles sont omniprésentes et les réseaux de neurones récurrents occupent une place privilégiées pour les traiter. Nous verrons dans cette première parties, les bases de ces réseaux récurrents et les principes des cellules LSTM ou GRU.

Effort : 0,5h Rythme : Auto-rythmé

FIDLE / CNRS

La controverse des neurones, Séquence 3

Intelligence Artificielle Outils pour l’IA : Réseaux multicouches et apprentissage machine

Le Deep Learning expliqué, en séquences courtes ! Le cycle complet comprend 9 séquences diffusées au fils de l’eau. Nous découvrirons dans cett vidéo comment fonctionnent ces réseaux multicouches et comment mettre en œuvre un processus d’apprentissage machine.

Effort : 0,6 Rythme : Auto-rythmé

FIDLE / CNRS

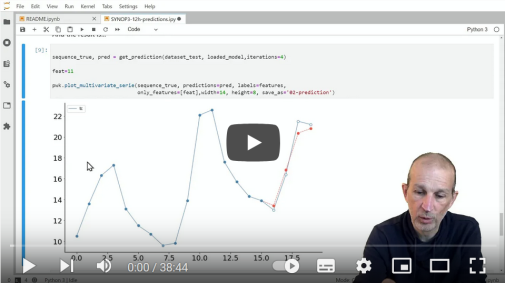

Prédiction météorologique

Intelligence Artificielle RNN : Exemple de réseaux récurrents

Prédiction météorologique Un autre exemple d’utilisation d’un RNN, avec une tentative de prévision météorologique à 3h et à 12h, à partir de données réelles.

Effort : 0,5h Rythme : Auto-rythmé

FIDLE / CNRS

Régression et Classification avec un DNN

Intelligence Artificielle Outils pour l’IA :Régression et classification

Le Deep Learning expliqué, en séquences courtes ! Le cycle complet comprend 9 séquences diffusées au fils de l’eau. Deux exemples de mise en œuvre avec une régression et une classification à l’aide de réseaux entièrement connectés (DNN). L’exemple de régression à pour objectif de prédire le prix d’une habitation à partir de caractéristiques du quartier (dataset Boston House Dataset)

Effort : 1h Rythme : Auto-rythmé

FIDLE / CNRS

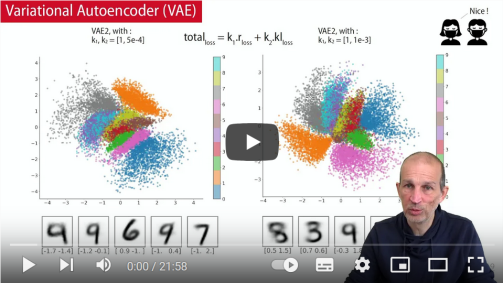

VAE : Implémentation d’un VAE

Intelligence Artificielle VAE : Implémentation d’un VAE

VAE : Implémentation d’un VAE (MNIST) Double exemple d’implémentation d’un Variational Autoencoder (VAE), en utilisant : - L’API fonctionnelle de Keras - L’utilisation d’une classe VAE, construite sur Keras Ces deux exemples sont illustrés avec le Dataset MNIST.

Effort : 0,6h Rythme : Auto-rythmé

FIDLE / CNRS

VAE : Variational Autoencoder

Intelligence Artificielle VAE : Variational Autoencode

VAE : Variational Autoencoder Du réseau autoencodeur (AE) au Variational Autoencoder (VAE)ou comment parcourir l’imagination de nos réseaux. Au programme : Principes et architecture d’un Variational Autoencoder (VAE).Problématiques liées à la gestion de "gros" datasets.Projection gaussienne - Génération de données - Morphing dans l’espace latent.Programmation avancée avec Keras - Datasets clusterisés.

Effort : 0,3h Rythme : Auto-rythmé

FIDLE / CNRS

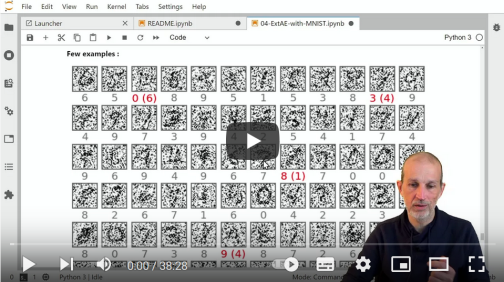

AE : Modèles avancés

Intelligence Artificielle AE : Modèles avancés d’autoencodeur

AE : Modèles avancés Implémentation de modèles avancés à double sorties et inception. L’objectif est de renforcer notre classifieur grâce à un apprentissage convolutif parallèle et différencié.

Effort : 0,6h Rythme : Auto-rythmé

FIDLE / CNRS

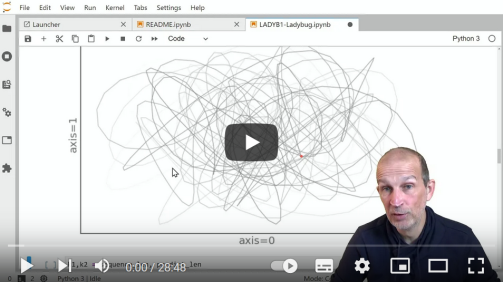

Prédiction simple d’une trajectoire

Intelligence Artificielle RNN : Exemple de réseaux récurrents

Exemple de prédiction simple d’une trajectoire Notre premier exemple d’utilisation d’un RNN va consister à essayer de prédire la trajectoire d’une coccinelle... virtuelle !

Effort : 0,5h Rythme : Auto-rythmé

FIDLE / CNRS

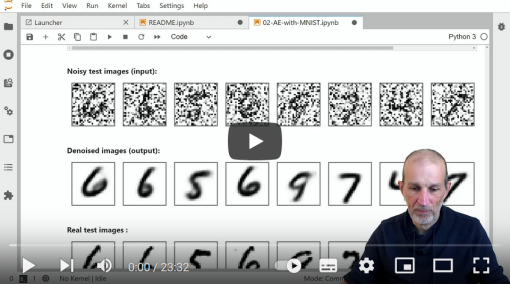

AE : Autoencodeur débruiteur

Intelligence Artificielle AE : Autoencodeur débruiteur

AE : Autoencodeur débruiteur Un premier exemple de réseau autoencodeur avec un débruiteur. Le dataset utilisé est MNIST.

Effort : 0,3h Rythme : Auto-rythmé

FIDLE / CNRS

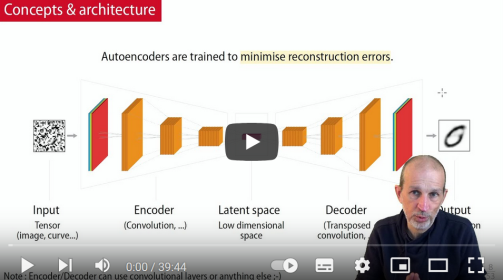

AE : Réseaux Autoencodeurs

Intelligence Artificielle AE : Réseaux Autoencodeurs

AE : Réseaux autoencodeurs Les autoencodeurs sont un bon exemple d’apprentissage non supervisé. Après une présentation des concepts et des couches convolutives (normales et transposées), nous nous intéresserons a la manière d’implémenter efficacement des modèles avancés avec l’API fonctionnelle de Keras.

Effort : 0,6h Rythme : Auto-rythmé